- Dragi gledatelji, opraštam se od vas, ovo je moja zadnja emisija Kod nas doma, prelazim u sportsku redakciju gdje ću komentirati boćanje, kriket i šah, rekao je urednik i voditelj Danijel Despot.

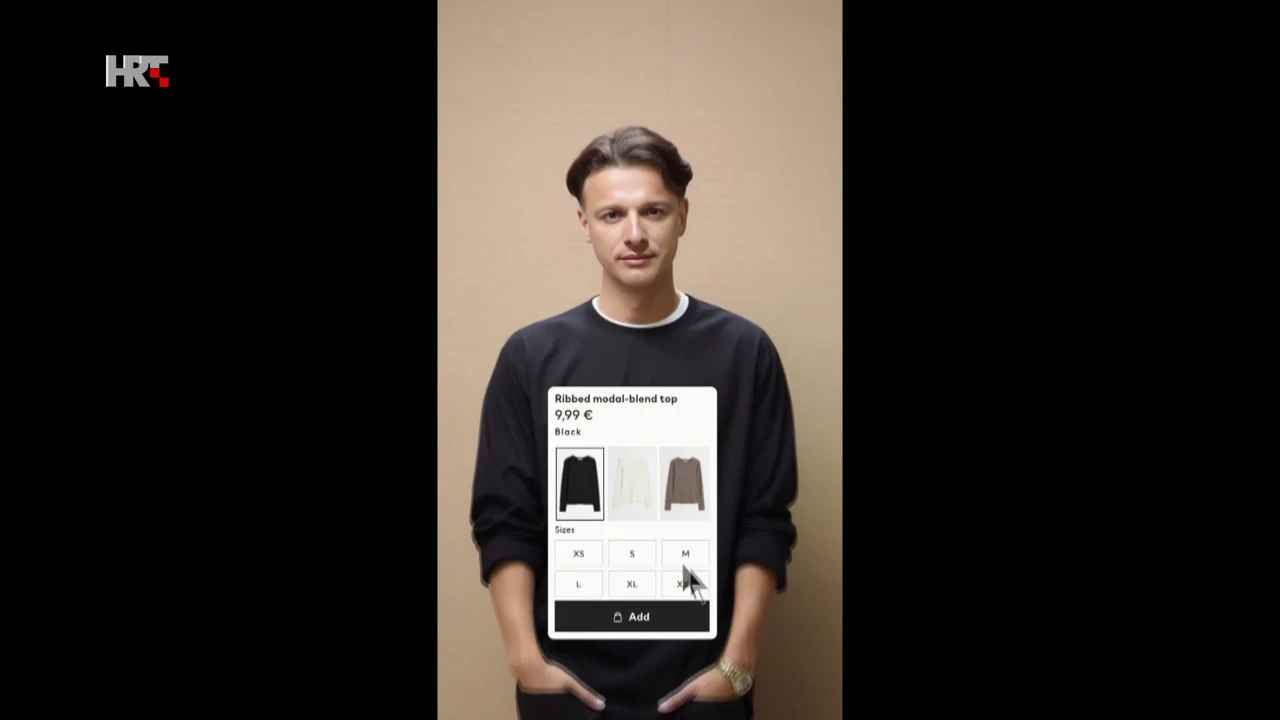

No to nije bio urednik i voditelj Danijel Despot misije Kod nas doma i on ne napušta tu emisiju. Nije bilo teško uočiti da je riječ o lažnom videu, ipak je u njega uloženo tek pet minuta, a sve što je bilo potrebno bile su dvije slike, nešto zvuka i program za umjetnu inteligenciju.

"Deepfake" ili na koje nas sve načine umjetna inteligencija može prevariti

08.02.2024.

17:40

Autor: Branka Suvajac Ljubičić/P.F./Kod nas doma/HRT

- Trenutno se može napraviti putem AI-ja, putem "deepfake"-a, baš svašta. Neki dan smo vidjeli kako gori Eiffelov toranj i to se proširilo po internetu i svi su mislili da fakat gori. Mislim da nas sad čeka jedan jako zanimljivo razdoblje u kojem nećemo znati što je stvarno, što nije, smatra Filip Filković - Philatz, redatelj, grafički dizajner i umjetnik.

A na razmišljanje što je stvarno, a što nije često tjeraju upravo Filipove objave na društvenim mrežama.

- Moja neka vizija je bila da napravim zapravo predsjednika i premijera kako su prijatelji jer mislim kako je to dobra slika. Da su oni stvarno prijatelji, pozitiva bi se širila sa samog vrha, čak i da "fejkaju" (op. a. glume) da su prijatelji, bilo bi puno bolje nego da se stalno događa nekakav clash (op. a. sukob). Ja koristim AI kako bi pokazao neku drugu sliku nekih ljudi koje pratimo u medijima. Svrha toga nije da ih se ismijava. Ja se nikome ne ismijavam putem toga nego naprosto samo ih stavljam u neku drugačiju sliku i kontekst, objasnio je Filković.

"Deepfake": Predsjednik i premijer su dobri prijatelji

Foto: Kod nas doma / HRT

Kako bi političari izgledali da se bave drugim zanimanjima, kako bi izgledali kao lica modnih kampanja, natjecatelji Milijunaša, likovi u igricama, pa i kao pljačkaši u dućanima uhvaćeni na djelu nadzornim kamerama, sve to možemo doznati zahvaljujući umjetnoj inteligenciji.

- Dok god je pod kontekstom humora, a u captionu (op. a. naslovu) te galerije je bio zapravo humor, ja to tretiram tako. Da sam to stavio na internet i napisao „Ej, gle, ulovili smo tog i tog kako je bježao iz dućana nakon što je ukrao čokoladicu, to je problem. Dakle to se može napraviti isto. Da je netko zlokoban mogao bi to napraviti, rekao je Filković.

I tu dolazimo do problema. Ovakve "deepfake" ili lažne video snimke danas možete napraviti uz par klikova. Sve što vam treba je snimka sebe ili vaše "mete" i slika osobe koja želite postati. Možete tako postati Johnny Depp ili Leonardo DiCaprio poput jednog od tiktokera. Primjerice, na jednoj snimci nije Tom Cruise što će primijetiti svatko tko malo ozbiljnije prouči snimku. No mnogi mu ljudi u komentarima svejedno žele uspjehe u novim filmovima.

Galerija

Osim za zabavu, lažne snimke danas se koriste i za prijevare. Nedavno je tako radnik jedne multinacionalne kompanije u Hong Kongu tvrtku koštao 25 milijuna dolara nakon što je nasjeo na lažni videopoziv u kojem je povjerovao da doista razgovara sa svojim nadređenima. Seksualno eksplicitan sadržaj u kojem je glavni lik Taylor Swift preplavio je nedavno internet. Riječ je, dakako, o lažnim snimkama slavne pjevačice. Mediji nagađaju da bi glazbena ikona zbog svega mogla pokrenuti pravni postupak, ali s obzirom na ograničeni zakon oko lažne pornografije, nije sasvim jasno kako bi to mogla učiniti.

- Većina država, pa tako i mi, zapravo se u ovom trenutku pozivamo na postojeće zakonske propise - što kaznenog zakona, što određenih prekršaja, što zakona o autorskim i srodnim pravima. Znači pronalazimo na što se uhvatiti da bismo mogli dokazati nešto za što je zapravo korišten "deepfake" ili općenito nekakvo lažiranje informacija. Ne postoje sada propisi koji se bave isključivo time, oni će postojati u budućnosti, naglasio je stručnjak za informacijsku sigurnost Alen Delić.

Stručnjak upozorava da ćemo se u ovoj superizbornoj godini susretati s različitim manipulacijama - više zvukom nego fotografijama i videom. Potencijal umjetne inteligencije za izbornu prijevaru zvukom na svojoj su koži već osjetili Amerikanci. Neki su su nasjeli na telefonski poziv u kojemu im je lažni Joe Biden uvjerljivim, njima prepoznatljivim, predsjedničkim glasom savjetovao da ostanu doma umjesto da izađu na izbore.

- Nešto što nekako svi imamo tendenciju raditi - vidimo nešto u što sumnjamo, ne potrošimo niti sekunde da provjerimo, da nađemo neki drugi izvor, da pitamo nekoga ima li možda neku drugu informaciju, nego to proslijedimo uz onu - "pa bolje da to proslijedimo, pa ako je istina - bolje da svi to znaju". A to bismo možda prvo trebali prestati raditi, smatra Delić.

Filković je optimističan, kaže kako se već radi na tome da jednim klikom doznamo radi li se o lažnoj fotografiji ili snimci, a sve dok se to ne dogodi jedini savjet je - ne vjerujte svemu što vidite i čujete.

Vijesti HRT-a pratite na svojim pametnim telefonima i tabletima putem aplikacija za iOS i Android. Pratite nas i na društvenim mrežama Facebook, Twitter, Instagram, TikTok i YouTube!

Od istog autora

Autorska prava - HRT © Hrvatska radiotelevizija.

Sva prava pridržana.

hrt.hr nije odgovoran za sadržaje eksternih izvora